-

파운데이션 모델(Foundation Model) 개발 현황카테고리 없음 2023. 6. 13. 00:37

ChatGPT로 발발된 언어모델 그리고 최근 눈부신 결과를 내고 있는 Foundation 모델에 대해서 궁금해졌다.

그래서, Survey를 통해 Foundation 모델 개발현황에 대해서 정리해보았다.

나중에 논문들을 차차 읽어가면서 확인해볼 예정이다.

또한 ChatGPT 등을 이용한 업무 효율화에 대해서 차곡차곡 정리해보려 한다.

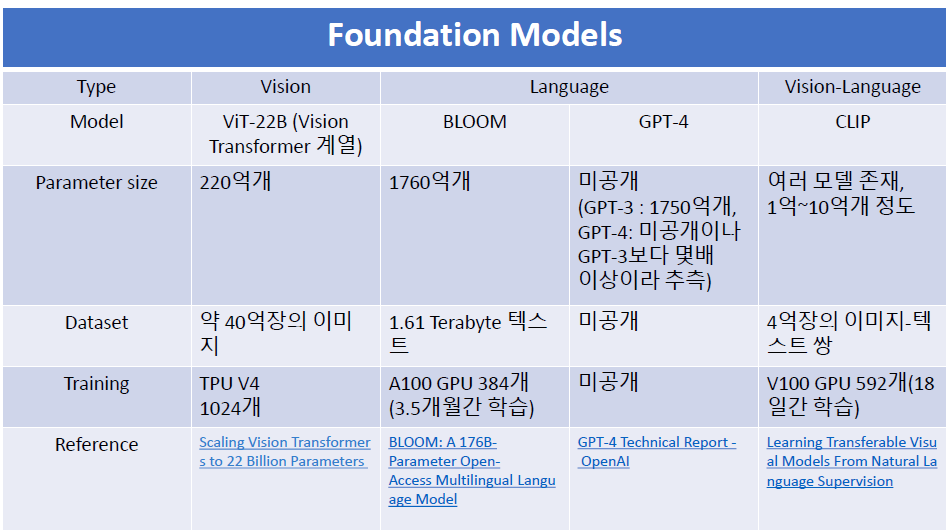

[Vision Foundation Model]

Scaling Vision Transformers to 22 Billion Parameters

- Model: ViT-22B (Vision Transformer 계열)

- Model Size: 220억개 parameter

- Dataset: 40억장 정도의 이미지들로 학습

- Training: 1024개의 TPU V4으로 학습[Language Foundation Model]

BLOOM: A 176B-Parameter Open-Access Multilingual Language Model

- Model: BLOOM

- Model Size: 1760억개 parameter

- Dataset: 1.61 Terabyte에 달하는 텍스트로 학습

- Training: 384개의 A100 GPU로 3.5개월간 학습GPT-4 Technical Report - OpenAI

- Model: GPT-4

- Model Size: 미공개(GPT-3의 경우, 1750억개 parameter, GPT-4는 알려지지 않았으나, GPT-3보다 몇배 이상이라 추측)

- Dataset: 미공개

- Training: 미공개

- 비고: GPT 계열은 Language Foundation Model 로 간주되지만, GPT-4는 이미지도 학습했을 것이라 판단됨. 구체적 설명은 나와있지 않음.[Vision-Language Foundation Model]

Learning Transferable Visual Models From Natural Language Supervision

- Model: CLIP

- Model Size: 여러 모델 종류가 있으며, 1억~10억개 정도의 parameter

- Dataset: 4억장의 이미지-텍스트 쌍으로 학습

- Training: 592개의 V100 GPU로 18일 동안 학습