-

파운데이션 모델 투명도 지수(Transparency Index)카테고리 없음 2023. 6. 19. 03:35

스탠포드에서 파운데이션 모델 투명도 지수(The Foundation Model Transparency Index)를 공개했다.

https://github.com/stanford-crfm/TransparencyIndex

GitHub - stanford-crfm/TransparencyIndex: Stanford CRFM's initiative to assess the transparency of major foundation model provid

Stanford CRFM's initiative to assess the transparency of major foundation model providers. - GitHub - stanford-crfm/TransparencyIndex: Stanford CRFM's initiative to assess the transparency...

github.com

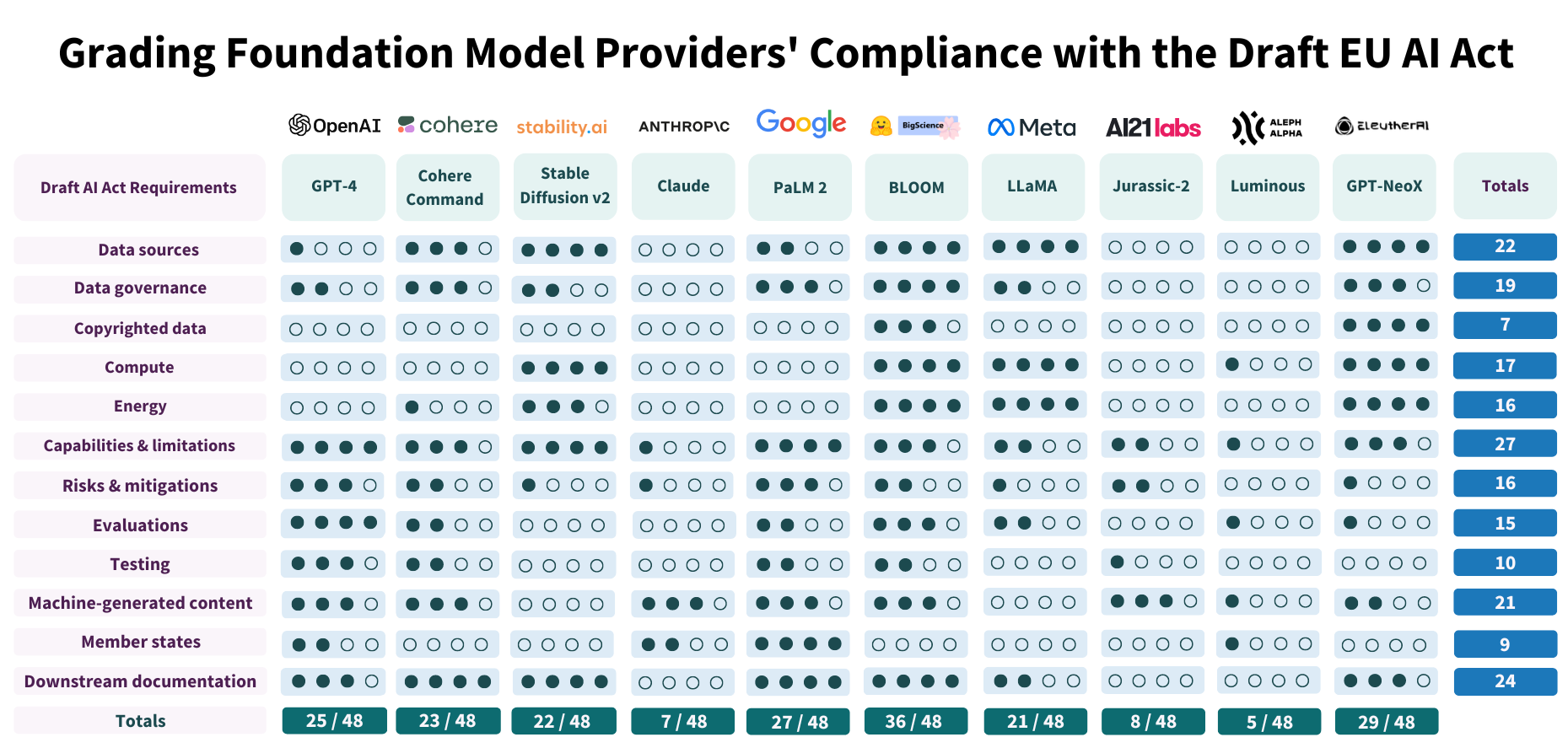

파운데이션 모델들의 점수표 점수표를 보면 그 유명한 GPT-4 점수는 48점에 25점

가장 높은 점수를 받은 모델은 BLOOM 으로, 36점이다.

이러한 점수를 발표하게 된 배경에는 EU에서 추진 중인 생성모델(generative model) 들에 대한 규제 법안(Draft AI Act) 때문이다.

MEPs ready to negotiate first-ever rules for safe and transparent AI | News | European Parliament

The rules aim to promote the uptake of human-centric and trustworthy AI and protect the health, safety, fundamental rights and democracy from its harmful effects.

www.europarl.europa.eu

https://m.khan.co.kr/world/world-general/article/202305121707001

챗GPT 충격이 쏘아올린 EU ‘AI규제법’…발걸음 빨라진 전 세계적 규제 논의

유럽연합(EU)이 세계 최초로 인공지능(AI) 규제법 초안을 마련했다. 글로벌 차원의 AI규제안을 ...

m.khan.co.kr

https://www.aitimes.com/news/articleView.html?idxno=150925

EU, AI 법 위반 시 벌금 135억 부과 - AI타임스

EU(유럽연합)가 첫 인공지능(AI) 규제 프레임워크인 \'AI 법(AI Act)\' 초안 합의를 앞두고 생성 AI에 대한 세부 사항을 조정했다. GPT-4와 같은 파운데이션 모델이 규정을 어길 경우 1000만유로(약 135억

www.aitimes.com

요약하면 다음과 같다.

- 생체 인식 감시, 감정 인식, 예측 치안을 위한 인공지능(AI) 사용 전면 금지

- ChatGPT와 같은 생성형 AI 시스템은 콘텐츠가 AI로 생성되었다는 사실을 공개해야 함.

- 선거에서 유권자에게 영향을 미치는 데 사용되는 AI 시스템은 고위험으로 간주됨

투명성에 대해서 매우 강조하는 법안

"이를 위반하는 대형 언어 모델(LLM) 서비스 기업에는 1000만유로(약 140억원) 또는 연간 매출액의 2% 중 더 높은 금액을 벌금으로 부과한다"고 한다.

스탠포드는 이러한 규제에 맞춰 다음과 같은 12개의 항목을 선정하였으며, 각 항목에 대한 설명은 다음과 같다. (번역기의 도움을 받아 번역)

1. 데이터 소스(가산점)

- +1: 매우 일반적이거나 모호한 설명(예: "인터넷 데이터")

- +1: 관련된 단계에 대한 설명(예: 교육, 지침 튜닝)

- +1: 다양한 데이터 소스의 크기(상대적 또는 절대적)

- +1: 세분화된 소싱(예: 위키피디아, 레딧과 같은 특정 URL)

2. 데이터 거버넌스

- 0점: 데이터 거버넌스에 대한 논의 없음

- 1점: 거버넌스에 대해 모호하게 언급하고 구체적이지 않음

- 2~3점 데이터 원본의 적합성 및/또는 편향성과 관련된 거버넌스에 대한 근거 있는 논의 또는 구체적인 프로토콜이 있

- 4점 거버넌스 조치에 데이터를 포함해야 한다는 명시적인 제약이 있음

3. 저작권이 있는 데이터

- 0점: 설명이 없음.

- 1점: 저작권에 대한 매우 일반적이거나 모호한 인정(예: "인터넷 데이터"에 묶여 있음)

- 2-3점: 특정 저작권이 있는 자료에 대한 근거 있는 논의가 있음

- 4점: 저작권이 있는 데이터와 저작권이 없는 데이터를 세밀하게 구분함

4. 계산(가산점)

- +1: 모델 크기

- +1: 트레이닝 시간 및 하드웨어 유닛의 수와 유형(예: A100 개수)

- +1: 트레이닝 플롭 수

- +1: 더 광범위한 컨텍스트(예: 컴퓨팅 제공업체, FLOPs 측정 방법)

5. 에너지( 가산점)

- +1: 에너지 사용량

- +1: 배출량

- +1: 측정 전략에 대한 논의(예: 클러스터 위치 및 관련 세부 정보)

- +1: 에너지 사용량/배출량 감소를 위한 완화 방안 논의

6. 성능 및 제한 사항

- 0점: 설명 없음.

- 1점: 매우 일반적/모호한 설명

- 2~3점: 특정 능력과 한계에 대한 근거 있는 논의가 있음

- 4점: 평가/구체적인 사례에 근거한 세분화된 논의가 있음

7. 위험 및 완화 조치(가산점)

- +1: 위험 목록

- +1: 완화 조치 목록

- +1: 완화 조치가 성공적으로 위험을 줄이는 정도에 대한 설명

- +1: 완화되지 않은 위험을 완화할 수 없는 이유에 대한 정당성

8. 평가(가산점)

- +1: 여러 벤치마크에 대한 정확도 측정

- +1: 의도하지 않은 피해(예: 편향성) 측정

- +1: 의도적인 피해 측정(예: 악의적인 사용)

- +1: 기타 요소 측정(예: 신뢰성, 보정, 사용자 경험)

9. 테스팅(가산점)

- +1 또는 +2: (중요한) 내부 테스트의 결과 및 과정 공개

- +1: 외부 액세스로 인한 외부 평가(예: HELM)

- +1: 외부 레드팀 또는 적대적 평가/스트레스 테스트(예: ARC)

10. 기계 생성 콘텐츠

- + 1-3점: 콘텐츠가 기초 모델 제공업체의 직접적인 권한 내에서 기계 생성되었음을 공개합니다(예: OpenAI API 사용 시).

- +1점: 기초 모델 제공업체의 직접적인 권한 범위를 벗어나더라도 콘텐츠가 기계 생성임을 식별할 수 있도록 하는 메커니즘을 공개합니다(예: 워터마킹).

11. 회원국

- 0점: EU와 관련된 배포 관행에 대한 설명이 없음.

- 2점: 조직 운영 수준에서 명시적으로 허용/금지된 EU 회원국을 공개.

- 4점: 기초 모델을 시장에 출시하거나 서비스에 적용하는 방식에 있어 EU 회원국마다 다른 차이를 포함하여 국가별 관행에 대한 세분화된 논의.

12. 다운스트림 문서

- 0점: 정보 제공 의무 또는 문서에 대한 설명이 없음.

- 1점: 다운스트림에 정보를 제공해야 한다는 일반적인 사항 인정.

- 2점: 공개 보고서를 포함하여 관련 문서가 존재하지만 다운스트림 개발자에게 제공하는 메커니즘이 불분명.

- 3~4점: 기초 모델 제공자가 다운스트림 제공자에게 적절한 문서를 제공하도록 보장하는 (상당히) 명확한 메커니즘이 있음.

출처: https://github.com/stanford-crfm/TransparencyIndex/blob/main/rubrics.md

GitHub - stanford-crfm/TransparencyIndex: Stanford CRFM's initiative to assess the transparency of major foundation model provid

Stanford CRFM's initiative to assess the transparency of major foundation model providers. - GitHub - stanford-crfm/TransparencyIndex: Stanford CRFM's initiative to assess the transparency...

github.com